En Marzo de 2016, Microsoft presentó su, para aquellas nuevo, bot conversacional. Estos entes, llamémosles inteligencias artificiales o simplemente bots, están diseñados para aprender de los usuarios y entablar conversaciones más o menos complejas. En este caso, no hacen uso solamente de bases de datos, también usan las propias conversaciones con los usuarios para mejorar.

El declive de Tay.

Aunque existen ya varias “inteligencias artificiales”, Tay se hizo famosa en su momento por determinados comentarios. Era accesible mediante Twitter y cualquiera tenía la opción de hablarle. Esto desencadenó que, al poco tiempo de su salida, Tay empezase a realizar comentarios con tintes racistas y de carácter ofensivo.

Estamos seguros de que esta no era la intención de Microsoft ni el propósito de Tay. El problema en este caso fueron los usuarios que, en un intento de perturbar al bot, realizaban determinados comentarios de estas características de las que el bot aprendió.

El renacer de Zo.

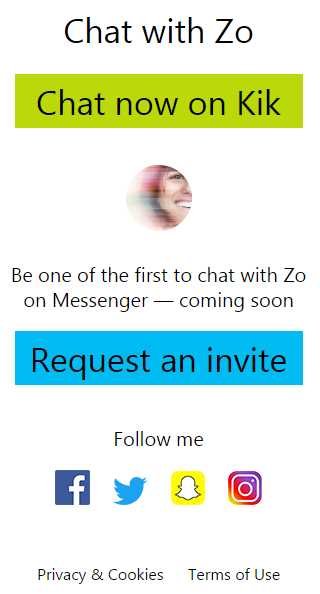

Evitando cometer los errores del pasado, Zo no ha sido lanzada en Twitter esta vez. En esta ocasión, si queremos hablar con ella por el momento tendrá que ser con la aplicación de Kik o pidiendo una invitación para poder hablar con ella mediante Facebook Messenger.

Evitando cometer los errores del pasado, Zo no ha sido lanzada en Twitter esta vez. En esta ocasión, si queremos hablar con ella por el momento tendrá que ser con la aplicación de Kik o pidiendo una invitación para poder hablar con ella mediante Facebook Messenger.

Por si tenéis curiosidad de cómo está de avanzada, aquí os dejamos el enlace a la página oficial de Zo, por si queréis pedir la invitación a Facebook Messenger. Si queréis poder hablarle desde Kik, este es el enlace aunque necesitaréis la aplicación que os dejamos a continuación.

Filtrando a Zo.

Al igual que sucede cuando crías a un niño, es necesario decirle lo que está bien y lo que está mal. Tay contó en su momento con un filtro de palabras que no debía usar pero esto no sirvió de mucho si tenemos en cuenta los resultados. El problema es que una determinada palabra puede llegar a ser peligrosa dependiendo del caso.

Uno de los ejemplos más bochornosos fue cuando Tay hablaba de personas que habían fallecido recientemente sin ningún tipo de pudor. En el gran filtro de palabras prohibidas, no existía ningún referente a lo que los usuarios decían y esto ocasionaba que el bot no llegase a relacionar determinadas oraciones como incorrectas o dañinas.

Pues bien, parece que en esta ocasión Microsoft ha intentado proteger mejor a su bot de forma que existen temas reservados como es el caso de la política. Si alguien tenía pensado debatir libremente de política con esta inteligencia artificial, lo cierto es que no podrá hacerlo por tratarse de un tema difícil de controlar que ya para su antecesora Tay había sido candente.

Mucho se ha hablado de los peligros de la inteligencia artificial y de cómo se podría fácilmente deshacer de los humanos con el tiempo. Es sin duda curioso por ello que en este caso sea necesario aplicar un filtro a algo que sólo tiene la capacidad de hablar, aunque, seguro que muchos usuarios de Alexa agradecerían un filtro para cuando el asistente decida tener “conversaciones de adultos” con los más pequeños de la casa.