El panorama de la Inteligencia Artificial sigue evolucionando a pasos agigantados, y si hay un campo que está viviendo una auténtica revolución, ese es el de la IA en dispositivos. Lo que hace no mucho parecía una promesa futurista, hoy es una realidad tangible que podemos llevar en el bolsillo. En este contexto, Google ha dado un paso adelante crucial para los desarrolladores de Android con el anuncio de su nueva herramienta: Automated Prompt Optimization (APO).

La era de la IA On-Device es ya una realidad

Desde el lanzamiento de Gemini Nano v3, una versión optimizada del aclamado modelo Gemma 3N, hemos visto cómo las capacidades de comprensión del lenguaje y multimodales han llegado directamente a las manos de los usuarios. Esta familia de modelos Gemini Nano ya cubre una amplia gama de dispositivos en el ecosistema Android, abriendo un abanico de posibilidades para la creación de aplicaciones inteligentes.

Sin embargo, para los desarrolladores, tener acceso a un modelo potente es solo el primer escalón. El verdadero desafío reside en la personalización: ¿cómo se puede adaptar un modelo fundacional para lograr un rendimiento experto en un caso de uso específico sin sobrepasar las limitaciones del hardware móvil?

El dilema de la adaptación en dispositivos

En el mundo de los servidores, los modelos de lenguaje grandes (LLM) suelen ser muy capaces y requieren menos adaptación al dominio. Incluso cuando es necesario, existen opciones avanzadas como el fine-tuning con LoRA (Low-Rank Adaptation), que resultan viables. No obstante, la arquitectura única de Android AICore, que prioriza un modelo de sistema compartido y eficiente en el uso de memoria, presenta un obstáculo. Desplegar adaptadores LoRA personalizados para cada aplicación individual se convierte en un reto considerable para estos servicios de sistema compartidos.

Presentamos Automated Prompt Optimization (APO)

Aquí es donde entra en juego APO. Google, a través de Vertex AI, ha desarrollado esta herramienta para ayudar a los desarrolladores a encontrar de forma automática el prompt óptimo para sus casos de uso. APO es una solución innovadora que promete una calidad comparable a la del fine-tuning, pero operando de manera fluida dentro del entorno de ejecución nativo de Android.

¿Cómo funciona la magia de APO?

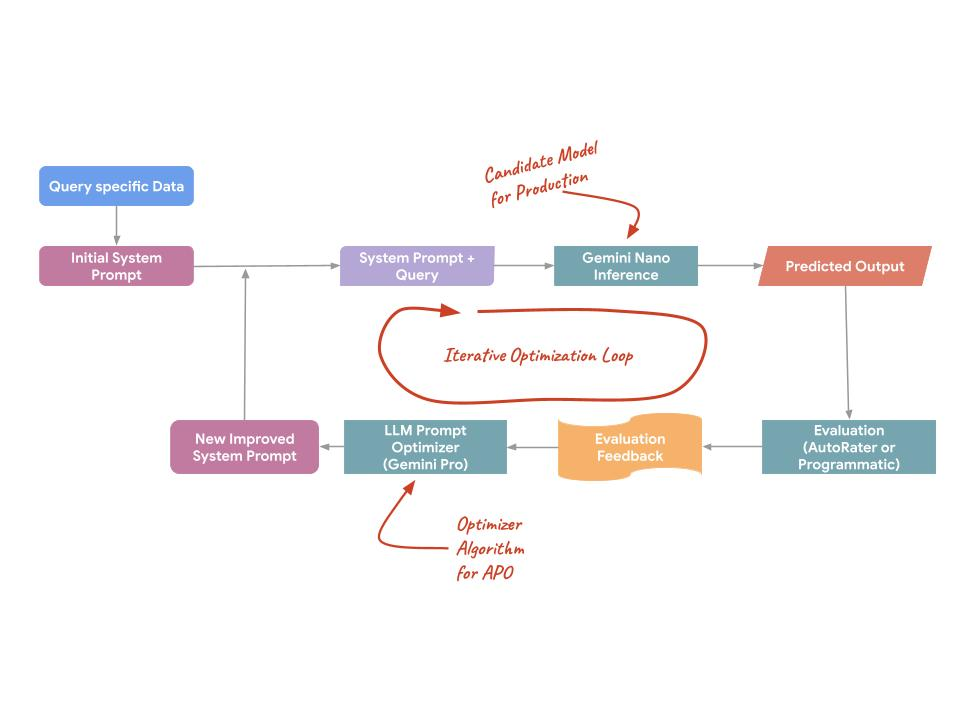

APO no trata el prompt como un texto estático, sino como una superficie programable que puede ser optimizada. Utiliza modelos del lado del servidor (como Gemini Pro y Flash) para proponer y evaluar variaciones de prompts, con el objetivo de encontrar el más eficaz para una tarea específica. Este proceso se apoya en tres mecanismos técnicos clave:

- Análisis automatizado de errores: APO analiza los patrones de error de los datos de entrenamiento para identificar automáticamente las debilidades específicas del prompt inicial.

- Destilación semántica de instrucciones: analiza grandes cantidades de ejemplos de entrenamiento para destilar la verdadera intención de una tarea, creando instrucciones que reflejan con mayor precisión la distribución real de los datos.

- Pruebas paralelas de candidatos: en lugar de probar una idea a la vez, APO genera y prueba numerosos candidatos de prompts en paralelo para identificar el máximo global de calidad.

¿Por qué APO puede igualar la calidad del Fine-Tuning?

Existe una idea errónea común de que el fine-tuning siempre ofrece una mejor calidad que la optimización de prompts. Para modelos fundacionales modernos como Gemini Nano v3, la ingeniería de prompts puede ser igual de impactante por sí misma:

- Preservación de capacidades generales: el fine-tuning (PEFT/LoRA) puede forzar las ponderaciones de un modelo a sobreindexarse en una distribución de datos específica. Esto a menudo lleva al "olvido catastrófico", donde el modelo mejora en una sintaxis específica, pero empeora en la lógica general y la seguridad. APO, al no tocar las ponderaciones, preserva las capacidades del modelo base.

- Seguimiento de instrucciones y descubrimiento de estrategias: Gemini Nano v3 ha sido rigurosamente entrenado para seguir instrucciones de sistema complejas. APO explota esto al encontrar la estructura de instrucción exacta que desbloquea las capacidades latentes del modelo, a menudo descubriendo estrategias que serían difíciles de encontrar para los ingenieros humanos.

Resultados concretos y mejoras significativas

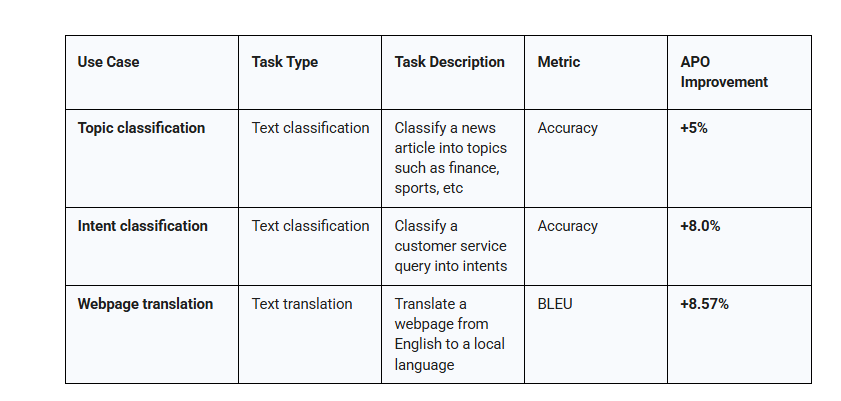

Para validar este enfoque, Google ha evaluado APO en diversas cargas de trabajo de producción, mostrando ganancias consistentes de precisión del 5-8% en varios casos de uso. Por ejemplo:

- Clasificación de temas: mejora del +5% en la precisión al clasificar artículos de noticias.

- Clasificación de intenciones: un +8% de mejora en la precisión para clasificar consultas de servicio al cliente.

- Traducción de páginas web: un aumento del +8.57% en la métrica BLEU para traducir páginas del inglés a idiomas locales.

Estos datos demuestran que APO no solo es una alternativa viable, sino una solución robusta y eficaz para mejorar la calidad de las aplicaciones de IA en dispositivos.

Un flujo de trabajo sencillo y eficaz para desarrolladores

El lanzamiento de Automated Prompt Optimization marca un punto de inflexión para la IA generativa en dispositivos. Al salvar la brecha entre los modelos fundacionales y el rendimiento de nivel experto, Google está dotando a los desarrolladores de las herramientas necesarias para construir aplicaciones móviles más robustas. Ya sea que estén comenzando con la optimización Zero-Shot o escalando a producción con refinamientos basados en datos, el camino hacia una inteligencia de alta calidad en el dispositivo es ahora mucho más claro.

APO, integrado con las ML Kit Prompt API y Vertex AI, ofrece un flujo de trabajo de desarrollo de principio a fin que facilita la implementación de casos de uso de IA en el dispositivo.